Índice

Durante o Microsoft Ignite, tradicional evento da criadora do Windows, a NVIDIA anunciou muitas novidades para desenvolvedores de aplicações para computadores de mesa e notebooks. Além do suporte para o ChatGPT ser implementado já no desenvolvimento de aplicativos para Windows, novidades sobre o Omniverse e criação de modelos de linguagem personalizados foram anunciadas. Veja tudo agora mesmo.

Maior suporte para desenvolvimento local

Atualmente, ainda é alto o número de desenvolvedores que precisam usar o poder de desempenho de uma nuvem para criar aplicações, uma vez que seus computadores não possuem o poder gráfico para as tarefas serem executadas sem problemas. Mas, quem tem ao menos uma placa de vídeo da série RTX da NVIDIA, deixará isso no passado.

Por meio de uma atualização do TensorRT-LLM, software de código aberto que aumenta o desempenho de inferência de IA, a NVIDIA permitirá que as aplicações sejam desenvolvidas localmente em vez de ficarem na nuvem. É claro que estes servidores entregam uma segurança completa, mas a empresa também espera que, com os dados de desenvolvimento salvos em um PC próprio do desenvolvedor, tudo seja mantido em ainda mais segurança.

Uma ferramenta que leva o nome de AI Workbench também foi anunciada: na prática, o kit de ferramentas para o desenvolvimento de aplicativos pode ser utilizado para a criação, testes e personalização de modelos de AI generativos pré-treinados. Também será possível fazer isso de forma local, no PC pessoal ou na estação de trabalho, sem a necessidade de realizar o envio para nuvem. O AI Workbench conta com uma “plataforma única” para a organização de projetos de AI e ajustes para casos específicos.

É possível demonstrar interesse para testar as novidades por meio do cadastro em uma lista de espera; ainda não há uma data certa para tudo ser lançado, mas é esperado que mais novidades apareçam durante a CES 2024.

Ao alterar apenas uma ou duas linhas de código, centenas de projetos e aplicativos de desenvolvedores com tecnologia de IA agora podem se beneficiar da IA local e rápida. Os usuários podem manter seus dados em seus PCs e não se preocupar em enviar conjuntos de dados para a nuvem.

Talvez a melhor parte seja que muitos desses projetos e aplicativos são de código aberto, tornando mais fácil para os desenvolvedores aproveitarem e ampliarem seus recursos para impulsionar a adoção de IA generativa no Windows, alimentada por RTX.

O wrapper funcionará com qualquer LLM que tenha sido otimizado para TensorRT-LLM (por exemplo, Llama 2, Mistral e NV LLM) e está sendo lançado como um projeto de referência no GitHub, junto com outros recursos de desenvolvedor para trabalhar com LLMs em RTX.

NVIDIA sobre atualização de kit de desenvolvimento TensorRT-LMM

Desenvolvimento otimizado

Outro anúncio que envolve a NVIDIA e Microsoft é que a API DirectML será lançada para permitir que um mesmo projeto de AI seja aproveitado em diferentes modelos. Isso evita a refação para que uma mesma ideia precise se adaptada para diferentes modelos. Entre os exemplos citados, será possível usar AIs como Llama 2 e Stable Diffusion para a criação de outras aplicações.

As empresas também confirmam que o desenvolvimento local será possível, com a exigência de que desenvolvedores façam tudo diretamente de seus computadores, sem a necessidade de mandar ou deixar tudo salvo na nuvem.

A novidade estará disponível a partir de 21 de novembro e é necessário seguir as instruções da Microsoft após a instalação do driver, por meio do site da NVIDIA.

RAG para tornar AIs mais confiáveis

Sendo a sigla para Retrieval-Augmented Generation, traduzida diretamente para Geração Aumentada de Recuperação, esta é a técnica para aprimorar modelos de linguagem existentes, por meio de fontes internas. O nome foi citado pela primeira vez em 2020 pelo autor Patrick Lewis, que escreveu um artigo completo sobre como AIs poderiam ser aprimoradas por meio de conteúdos disponíveis apenas fora da internet.

O conceito é até que simples: por meio da digitação de cinco linhas de código de programação, os desenvolvedores irão permitir que os modelos de linguagem (que são a “fonte” de conhecimento das inteligências artificiais) acessem conteúdos de livros que até então estavam disponíveis apenas na vida real.

Em outras palavras, o RAG preenche uma lacuna sobre como os modelos de linguagem funcionam. Nos bastidores, modelos de linguagem são redes neurais, normalmente medidas pela quantidade de parâmetros que possuem. Os parâmetros de um modelo de linguagem representam os padrões gerais de como os humanos usam palavras para formar frases. Essa compreensão profunda, às vezes chamada de conhecimento parametrizado, torna os modelos de linguagem úteis para responder a solicitações gerais na velocidade da luz, porém, não atende usuários que desejam se aprofundar em um tema atual ou mais específico.

NVIDIA sobre o lançamento do RAG

Empresas como Amazon WebServices, Microsoft, Google, Oracle, Pinecone e Microsoft estão entre as primeiras que usarão a nova técnica para melhorar suas inteligências artificiais. É necessário um alto poder de desempenho para o uso do RAG, então servidores como o superchip Grace Hopper NVIDIA H200, que possui 288 GB de memória HBM3e e 8 petaflops de computação, serão mais que essenciais para o uso do RAG.

Novo modelo de linguagem

Durante o Microsoft Ignite, a NVIDIA apresentou seu novo modelo de linguagem que leva o nome de Nemotron-3 8B. Ele consegue dar apoio para a criação de chatbots empresariais que respondem perguntas complexas sobre os mais diversos segmentos, incluindo finanças, saúde, varejo, governamentais, telecomunicação, mídia e entretenimento, manufatura e energia.

O Nemotron-3 8B também possui suporte para mais de 50 idiomas, incluindo português, inglês, espanhol, japonês, chinês, alemão, russo, francês, e muito mais. A NVIDIA também confirma o modelo de linguagem pode recebe dados de empresas para o desenvolvimento personalizado de uma AI seja realizado sem problemas.

O propósito da empresa é permitir a criação de aplicativos de IA generativa seguros e prontos para produção. Esses modelos são treinados em conjuntos de dados de origem responsável e operam com desempenho comparável a modelos muito maiores, tornando-os ideais para implantações empresariais.

Depois que os modelos são personalizados, os usuários podem implantá-los praticamente em qualquer lugar com segurança, estabilidade e suporte de nível empresarial usando o NVIDIA IA Enterprise. Isso inclui o NVIDIA TensortRT-LLM para inferência de aprendizado profundo de alto desempenho para fornecer baixa latência e alto rendimento para cargas de trabalho de inferência de IA.

NVIDIA sobre o lançamento de seu modelo de linguagem

A disponibilidade do Nemotron-3 8B acontece a partir de hoje (15 de novembro), seja por meio do NVIDIA NGC, via Hugging Face ou marketplace do Microsoft Azure.

Parceria NVIDIA x Amdocs

Empresas de todo o mundo reconhecem que as IAs generativas chegaram para mudar a forma como trabalhamos hoje. Com o lançamento do novo modelo de linguagem, a Amdocs, que atua no mercado de telecomunicações e mídia e dá suporte para 27 dos 30 provedores de serviços do mundo.

A empresa, que também atua no Brasil, usará o novo modelo de linguagem e os já disponíveis no NVIDIA AI Foundation para oferecer resultados mais precisos para seus cases de sucesso. A empresa espera otimizar dados e atendimento ao cliente, tarefas que antes levavam bastante tempo para serem executadas.

Alimentando mais de 1,7 bilhão de jornadas digitais diárias, as plataformas Amdocs impactam mais de 3 bilhões de pessoas em todo o mundo. A NVIDIA e a Amdocs estão explorando vários casos de uso de IA generativa para simplificar e melhorar as operações, fornecendo recursos de IA generativa seguros, econômicos e de alto desempenho. Os primeiros usos abrangem o atendimento ao cliente, incluindo a aceleração da resolução de dúvidas dos clientes, extraindo informações de dados da empresa.

NVIDIA sobre sua parceria com a Amdocs

Omniverse agora simula uso de carros inteligentes

O Omniverse da NVIDIA é uma aplicação que pode ser utílizado para a criação de jogos, projetos de arquitetura e engenharia e até mesmo em simulações no âmbito virtual antes de um produto (como um carro) seja de fabricado.

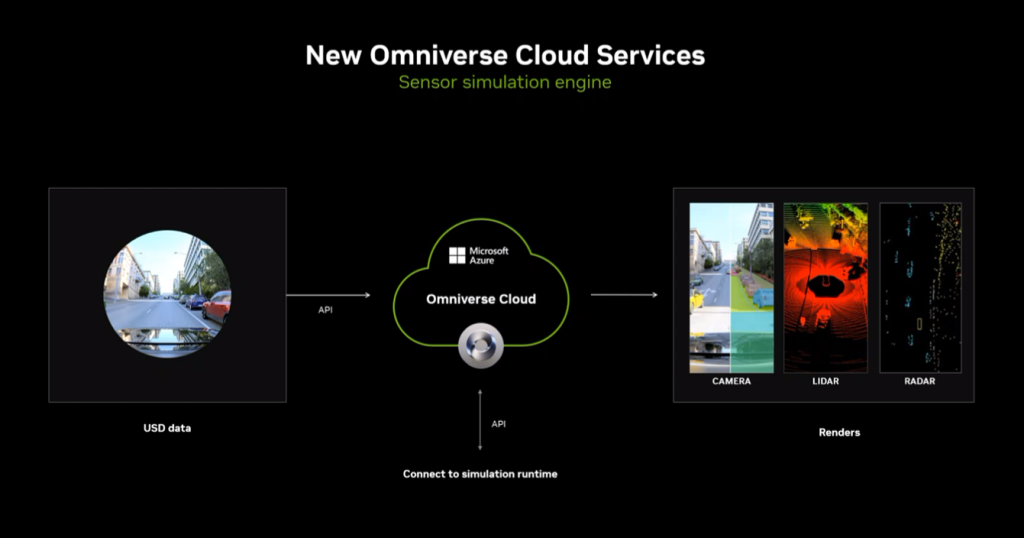

Ao final do evento de hoje, foi anunciado que empresas de carros inteligentes como a Mercedes-Benz estão usando a aplicação para criar projetos e manter tudo no virtual antes que os testes no mundo real se iniciem, por meio da solução de simulação de fábrica. Além disso, usuários da nuvem Microsoft Azure poderão usar o aplicativo de forma integrada e sem custo adicional.

O processo foi explicado pela NVIDIA: após o envio de informações sobre o carro, incluindo detalhes técnicos, a inteligência artificial consegue colocar a ideia para rodar em um ambiente virtual. Os desenvolvedores poderão conferir detalhes sobre o uso de sensor LIDAR, ver a câmera em tempo real e também testar sensores de radar. Tudo sendo apresentado em 3D.

O mecanismo de simulação de fábrica virtual Omniverse Cloud é uma coleção de aplicativos e serviços de desenvolvedor personalizáveis que permitem que as equipes de planejamento de fábrica conectem conjuntos de dados industriais em grande escala enquanto colaboram, navegam e os revisam em tempo real.

Mesmo que cada empresa de carros autônomos tenham seus próprios aplicativos ou usem aplicações de terceiros, o funcionamento acontecerá da mesma forma. Os interessados devem entrar em contato com a NVIDIA por meio do marketplace do Microsoft Azure, pois é necessário fazer algumas adaptações para que o uso aconteça de forma personalizada.

Gostou das novidades? Diga pra gente nos comentários!

Veja também

Lenovo e NVIDIA anunciam parceria em soluções híbridas de IA para empresas

Com informações: Microsoft Ignite

Revisado por Glauco Vital em 15/11/23.

Descubra mais sobre Showmetech

Assine para receber nossas notícias mais recentes por e-mail.