Índice

Hoje (25) aconteceu o Meta Connect 2024, evento da empresa responsável pelo Facebook, Instagram e WhatsApp, com o anúncio de suas novidades tecnológicas, apresentado pelo próprio Mark Zuckerberg. Além dos óculos holográficos Orion, ainda vimos novidades sobre o Llama 3.2 e o Meta AI — que integra todas as redes sociais da empresa. Veja agora os destaques sobre a inteligência artificial do Meta

Novidades que chegam com a Llama 3.2

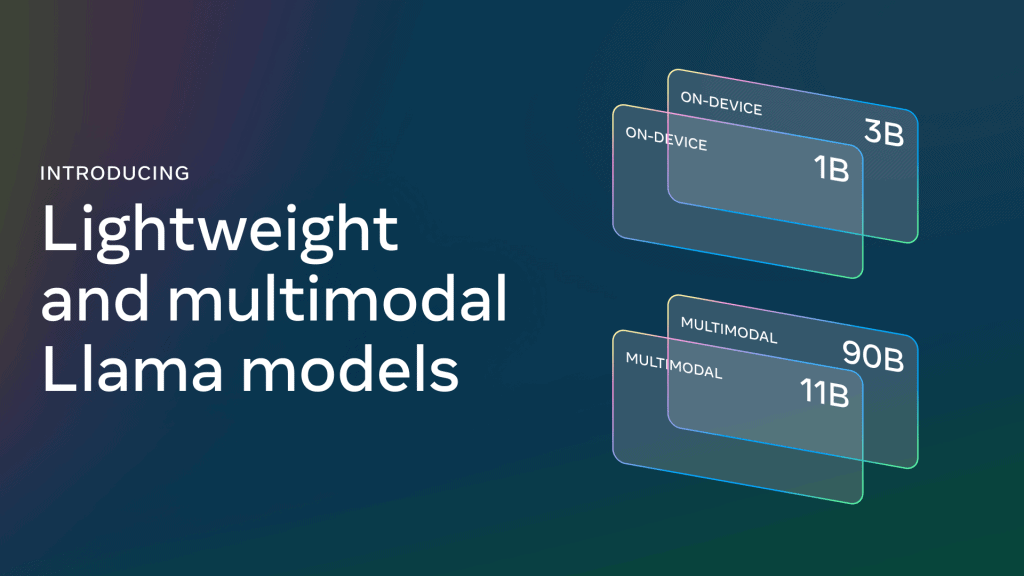

Os dois maiores novos modelos da coleção Llama 3.2, com 11B e 90B (11 e 90 bilhões, respectivamente) de parâmetros, destacam-se por seu suporte a tarefas de raciocínio visual, como a compreensão de documentos complexos, incluindo tabelas e gráficos, além de legendas de imagens e identificação de objetos em cenas visuais com base em descrições em linguagem natural.

Um exemplo prático envolve a capacidade do Llama 3.2 de analisar gráficos para responder rapidamente a perguntas sobre o desempenho de vendas de uma empresa em um determinado mês. Em outro caso, o modelo pode interpretar mapas, indicando quando uma trilha se torna mais íngreme ou a distância de uma rota específica. Esses modelos avançados também conectam visão e linguagem, sendo capazes de extrair detalhes de uma imagem e gerar legendas para descrever a cena.

A Meta também anunciou modelos mais leves, de 1B e 3B parâmetros, para aparelhos menores, como smartphones e óculos inteligentes. Estes foram feitos para geração de texto multilíngue e execução de comandos automatizados. Eles possibilitam o desenvolvimento de aplicativos personalizáveis que funcionam diretamente nos dispositivos, garantindo privacidade total, já que os dados não são enviados para a nuvem. Esses aplicativos podem resumir mensagens recebidas e identificar itens importantes para enviar convites de calendário diretamente, utilizando a funcionalidade de chamadas de ferramentas.

Executar os modelos localmente traz duas vantagens principais: respostas quase instantâneas, devido ao processamento direto no dispositivo, e maior privacidade, ao evitar o envio de dados sensíveis para a nuvem. Isso permite que o controle sobre quais consultas permanecem no dispositivo e quais podem ser processadas por modelos maiores na nuvem seja feito de forma clara e segura.

Este trabalho foi apoiado por nossos parceiros em toda a comunidade de IA. Gostaríamos de agradecer e reconhecer (em ordem alfabética): Accenture, AMD, Arm, AWS, Cloudflare, Databricks, Dell, Deloitte, Fireworks.ai, Google Cloud, Groq, Hugging Face, IBM watsonx, Infosys, Intel, Kaggle, Lenovo, LMSYS, MediaTek, Microsoft Azure, NVIDIA, OctoAI, Ollama, Oracle Cloud, PwC, Qualcomm, Sarvam AI, Scale AI, Snowflake, Together AI e UC Berkeley – Projeto vLLM.

Agradecimento da Meta em seu site

Novos recursos da Meta AI

E as novidades não param por aí! O Meta AI será beneficiado com as seguintes novidades:

Vozes no WhatsApp, Instagram, Facebook e Messenger

Mark Zuckerberg anunciou uma nova atualização nos assistentes de IA da Meta, que agora contarão com vozes de celebridades, como Dame Judi Dench, John Cena, Awkwafina, Keegan Michael Key e Kristen Bell. A ideia é tornar a interação mais natural e divertida, oferecendo uma experiência personalizada em plataformas como Facebook, Messenger, WhatsApp e Instagram.

Além das novas vozes, uma das inovações mais significativas é a habilidade dos modelos de IA de interpretar fotos e outras informações visuais dos usuários, ampliando as alternativas de interações e oferecendo respostas ainda mais contextuais e relevantes para cada usuário.

Ver, explicar e editar imagens

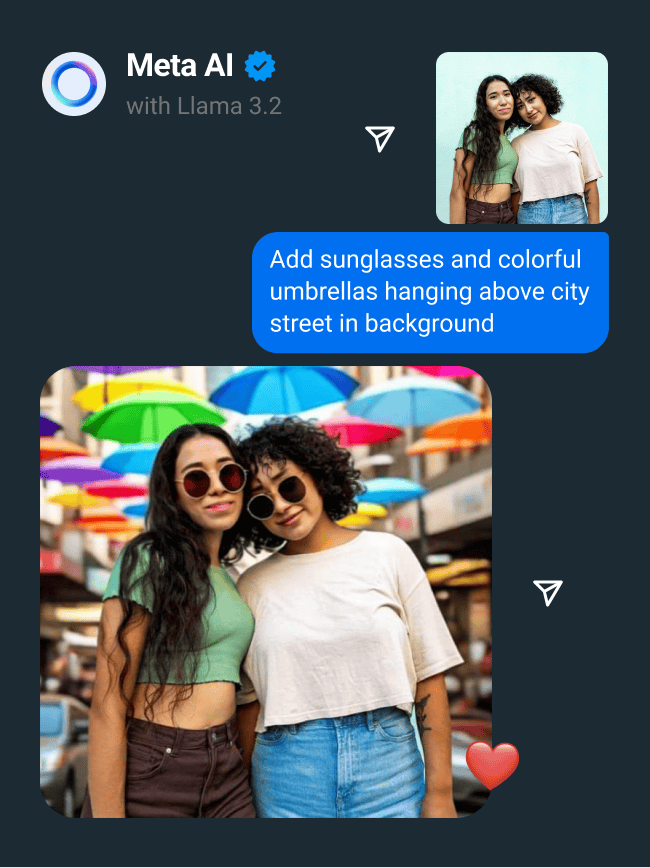

Também foi expandido o recurso de edição do Meta AI, permitindo que ele processe informações visuais. Agora será possível tirar uma foto de uma flor durante uma caminhada e pedir ao Meta AI para identificá-la e/ou explicar mais sobre ela, ou fazer o upload de uma imagem de um prato e receber a receita correspondente.

Os usuários também poderão fazer edições detalhadas em suas fotos reais usando comandos em linguagem cotidiana, como adicionar ou remover elementos. Anteriormente, esse recurso só funcionava em imagens geradas pelo Meta AI, mas agora está disponível para fotos tiradas pelos usuários, facilitando ajustes personalizados.

Com a função Imagine do Meta AI, será possível se inserir em histórias, postagens de feed e até mesmo na sua foto de perfil no Facebook e Instagram, compartilhando selfies geradas por IA de maneira interativa. A IA também pode sugerir legendas para suas histórias no Instagram e Facebook. Basta escolher uma imagem, e o Meta AI irá sugerir diversas opções de legendas, facilitando a escolha da que mais se adequa à sua postagem.

Dublagem com sincronização labial em Reels

Atualmente, a Meta também está testando a dublagem automática de vídeos com sincronização labial nos Reels do Instagram e Facebook, começando com os idiomas inglês e espanhol. Essa funcionalidade permitirá que os usuários assistam ao conteúdo em seu idioma nativo, facilitando a compreensão e a interação.

Inicialmente, o recurso está disponível para um pequeno grupo de criadores, mas há planos de expandi-lo para mais criadores e incluir outros idiomas em breve. Este avanço tem o potencial de aumentar significativamente o alcance dos criadores de conteúdo, permitindo que suas produções ultrapassem barreiras linguísticas e se conectem com um público global, independentemente da língua falada.

Disponibilidade

A empresa afirma que o Llama 3.2 já está disponível nas plataformas do Meta, com exceção das atualizações de voz do Meta AI. Estas estão disponíveis na Austrália, Canadá, Nova Zelândia e EUA apenas em inglês.

E você, o que achou das novidades? Conta pra gente nos comentários!

Veja também:

Meta mostra óculos holográficos Orion, que exibem imagens na tela.

Com informações de: Meta [1] e [2].

Revisão do texto feita por: Daniel Coutinho (25/09/24)

Descubra mais sobre Showmetech

Assine para receber nossas notícias mais recentes por e-mail.