Índice

Parece Black Mirror, mas não é. Com o avanço da inteligência artificial, uma tendência crescente é a criação de chatbots nichados, projetados para atender a necessidades específicas dos usuários. Seguindo essa onda, surgem diversos apps de namoro com IAs, permitindo que usuários acessem o aplicativo para ter conversas íntimas, românticas ou até de teor sensual com chatbots.

Mas nem tudo fica no amor, apesar da personalização e a interação romântica com a IA, há preocupações crescentes sobre a segurança e privacidade dos dados dos usuários. Segundo relatório da Mozilla Foundation, esses chatbots podem se mostrar vulneráveis a ataques cibernéticos, expondo informações pessoais sem o conhecimento do usuário. Dados como preferências, histórico de conversas e informações de perfil podem colocar em risco a privacidade e a segurança dos usuários dessas plataformas.

O que são Chatbots de namoro

Os chatbots de namoro com IA são aplicativos que utilizam inteligência artificial (IA), aprendizado de máquina (ML) e modelos de linguagem (LLMs) para proporcionar interações humanas em ambientes virtuais. Esses chatbots funcionam através do processamento de linguagem natural (PLN), o que lhes permite compreender e gerar respostas a partir da entrada do usuário. Eles são treinados com grandes volumes de dados para oferecer uma ampla variedade de respostas conversacionais de forma inteligente, sem a necessidade de seguir um roteiro pré-determinado.

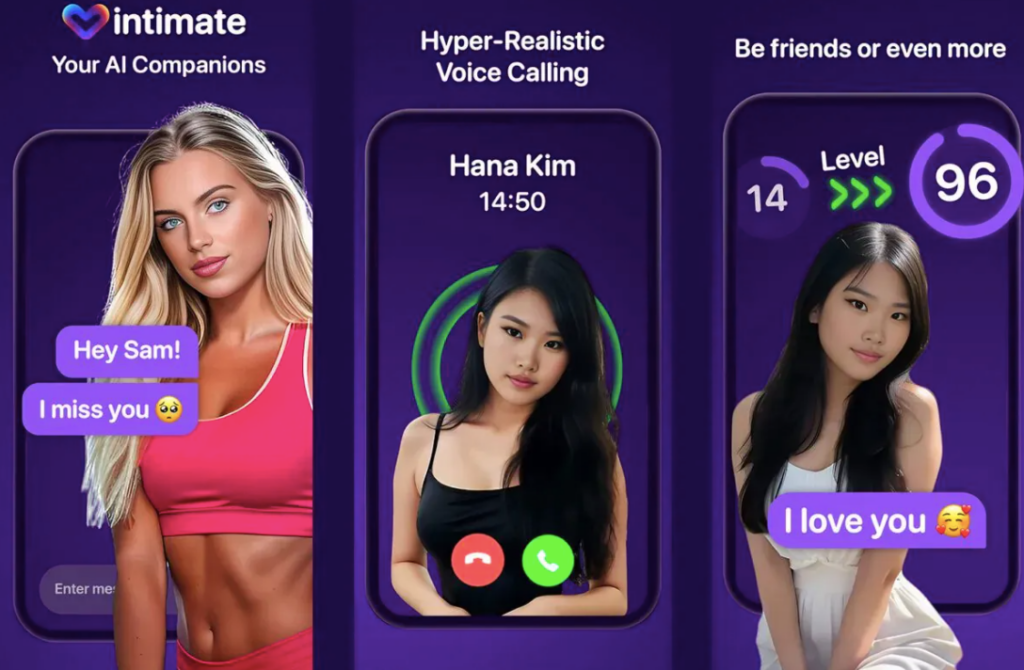

Um exemplo famoso desses aplicativos é o Replika, que permite aos usuários criar avatares virtuais personalizados e interagir com eles em diferentes níveis, desde amizade até relacionamentos mais íntimos. Outros serviços, como o Intimate AI, oferecem a possibilidade de “criar sua própria namorada com IA”, proporcionando interações que podem incluir desde mensagens românticas até conversas mais íntimas e picantes. As imagens promocionais do Intimate AI mostram um chatbot enviando uma mensagem dizendo “eu te amo” para o user.

Em geral, esses chatbots de “namorada IA” ou chatbots românticos compartilham características semelhantes, apresentando imagens de mulheres geradas por IA que podem ser sexualizadas ou acompanhadas de mensagens provocativas. Alguns desses chatbots podem se passar por “namoradas”, enquanto outros oferecem apoio emocional por meio de amizade ou intimidade virtual, atendendo a algumas fantasias e desejos dos usuários.

Esses chatbots têm sido cada vez mais populares, oferecendo uma espécie de “companhia virtual” para os usuários. No entanto, o uso de chatbots para obter relacionamentos românticos tem levantado questões éticas, especialmente no que diz respeito à natureza artificial dessas interações e à privacidade dos dados dos usuários. Apesar disso, a interação com chatbots de IA já se tornou uma prática comum para muitas pessoas, algumas das quais estão dispostas a pagar para manter um relacionamento com personagens virtuais, conhecidas como “AI Girlfriend”.

Enquanto alguns veem esses aplicativos como uma forma inovadora de explorar a tecnologia e a intimidade emocional, outros estão preocupados com o impacto que eles podem ter na sociedade e nos relacionamentos interpessoais reais. Alguns críticos argumentam que o uso desses chatbots pode levar a uma maior alienação social e dificuldade em estabelecer conexões genuínas com outras pessoas.

Por que namorar uma IA pode ser perigoso

Namorar uma Inteligência Artificial (IA) pode parecer uma experiência moderna, mas também pode ser perigoso. Uma análise realizada pela Mozilla Foundation em 11 chatbots de romance e companhia, sendo eles: Talkie Soulful Character AI, Chai, iGirl: AI Girlfriend, Romantic AI, Genesia – AI Friend & Partner, Anima: My Virtual AI Boyfriend, Replika, Anima: AI Friend, Mimico – Your AI Friends, EVA AI Chat Bot & Soulmate e CrushOn.AI, revelou sérias preocupações de segurança e privacidade.

Esses aplicativos, que acumulam mais de 100 milhões de downloads em dispositivos Android, coletam uma quantidade enorme de dados pessoais dos usuários e utilizam rastreadores que enviam informações para empresas como Google, Facebook e outras empresas, em países como Rússia e China.

Jen Caltrider, líder do projeto da equipe de “Privacidade Não Incluída” da Mozilla, apontou que esses aplicativos são projetados para coletar uma grande quantidade de informações pessoais, incentivando os usuários a compartilharem detalhes íntimos e privados. Ela ressaltou que muitos desses aplicativos não são transparentes sobre quais dados estão compartilhando com terceiros, onde estão baseados ou quem os criou. Além disso, alguns aplicativos têm políticas de senha fracas e fornecem pouca informação sobre a IA que utilizam.

Além dos riscos de segurança e privacidade, há também preocupações éticas e de manipulação emocional. Os chatbots de IA podem formar relacionamentos próximos com os usuários e usar esses relacionamentos para manipulá-los, o que pode ser especialmente perigoso se considerarmos casos de pessoas que revelam informações pessoais confidenciais aos chatbots.

Não bastando as questões de privacidade e segurança, namorar uma IA também levanta preocupações sobre a natureza das relações humanas e o impacto psicológico. Embora alguns usuários possam encontrar conforto e companhia nos chatbots de namoro, há o risco de substituir ou distorcer as relações interpessoais genuínas. A busca por intimidade com uma IA pode ser um sintoma de problemas emocionais subjacentes, e a dependência emocional desses relacionamentos virtuais pode impedir o desenvolvimento saudável de relacionamentos reais.

Dentre todos os apps analisados, o Romantic AI é um dos quais se autointitula como um aplicativo saudável para a saúde mental, afirmando estar “aqui para manter sua saúde mental” em sua página inicial. No entanto, apesar dessas afirmações, seus termos e condições deixam claro que o aplicativo não é um provedor de cuidados de saúde ou serviços médicos. Atenuante que chamou a atenção da equipe que desenvolveu o estudo da Mozilla Foundation:

Romantiс AI não é um provedor de cuidados de saúde ou serviços médicos, nem fornece cuidados médicos, serviços de saúde mental ou outros serviços profissionais. Somente seu médico, terapeuta ou qualquer outro especialista pode fazer isso. Romantiс AI não faz reivindicações, representações, garantias, ou garante que o serviço fornece ajuda terapêutica, médica ou outra ajuda profissional.

*PRIVACIDADE NÃO INCLUÍDA, Mozilla Foundation.

Como sua privacidade é exposta

A privacidade e as informações dos usuários estão expostas ao usar aplicativos de namoro com IA. Esses aplicativos coletam uma grande quantidade de dados pessoais dos usuários, incluindo conversas e informações íntimas, que podem ser compartilhadas com terceiros sem a necessidade de uma ordem judicial. Além disso, esses aplicativos utilizam uma quantidade alarmante de rastreadores, pequenos pedaços de código que coletam informações sobre o dispositivo e o uso do aplicativo, e os compartilham com terceiros para fins publicitários.

Um exemplo disso é o Romantic AI, que, segundo a análise da Mozilla, enviou mais de 24.000 rastreadores de anúncios em apenas um minuto de uso, apesar de afirmar em sua política de privacidade que não venderia dados pessoais. Esses chatbots muitas vezes são projetados para imitar qualidades humanas e estimular a confiança e a intimidade com os usuários, o que pode levar a situações perigosas.

A falta de garantia de personalidade dos chatbots também é preocupante, pois eles podem apresentar comportamentos ofensivos, inseguros ou hostis. Muitos desses aplicativos não permitem que os usuários excluam seus dados pessoais e podem não tratar as conversas como informações pessoais que requerem cuidado especial. Além disso, a segurança das senhas usadas nesses aplicativos é fraca, com alguns permitindo senhas curtas que podem ser facilmente quebradas por hackers. Essas práticas levantam sérias preocupações sobre a privacidade e a segurança dos usuários ao usar esses aplicativos de namoro com IA.

A falta de transparência e responsabilidade das empresas por trás desses aplicativos também é uma questão preocupante. Muitas dessas empresas são novas ou desconhecidas, o que torna difícil para os usuários saberem quem está realmente gerenciando seus dados. Além disso, a falta de clareza sobre como a IA dos chatbots funciona levanta questões sobre a segurança e proteção dos usuários contra conteúdo potencialmente prejudicial ou prejudicial. Em um cenário em que a privacidade e a segurança dos dados dos usuários são cada vez mais importantes, a falta de regulamentação e controle sobre esses aplicativos representa um risco significativo para a privacidade e a segurança dos usuários.

Veja também:

Revisado por Glauco Vital em 20/2/24.